麻仓优快播 谷歌&MIT何恺明团队:视觉大模子像LLM相同高效推广

梦晨 发自 凹非寺麻仓优快播

量子位 | 公众号 QbitAI视觉自回首模子的Scaling,时时不像在说话模子里那样有用。

谷歌&MIT何恺明团队联手,有望突破这一场地,为自回首文生图模子的推广指出一个标的:

基于开发token的模子比错杂token模子在视觉质地上更好。立时法例生成与光栅法例比拟在GenEval测试上得分昭着更好。

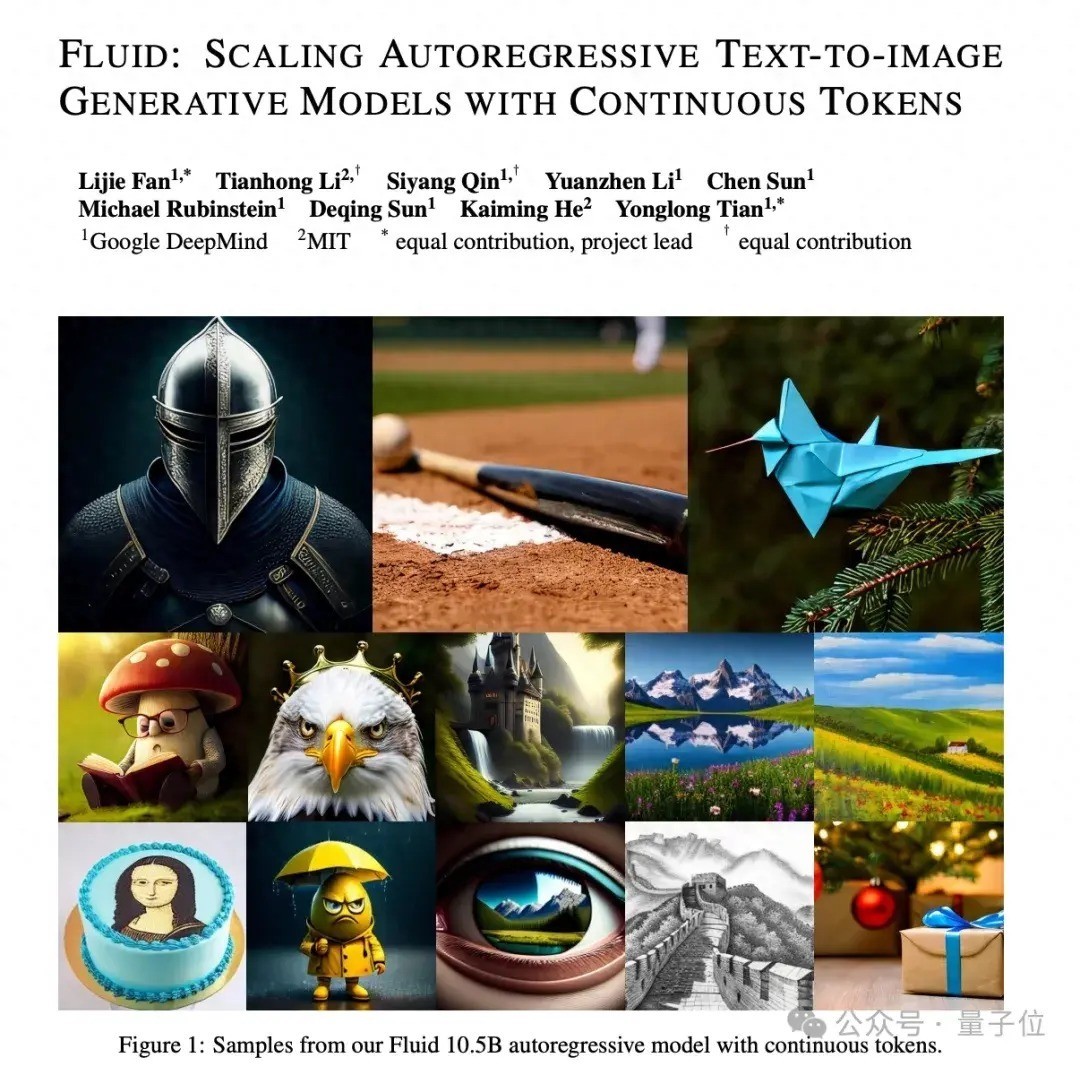

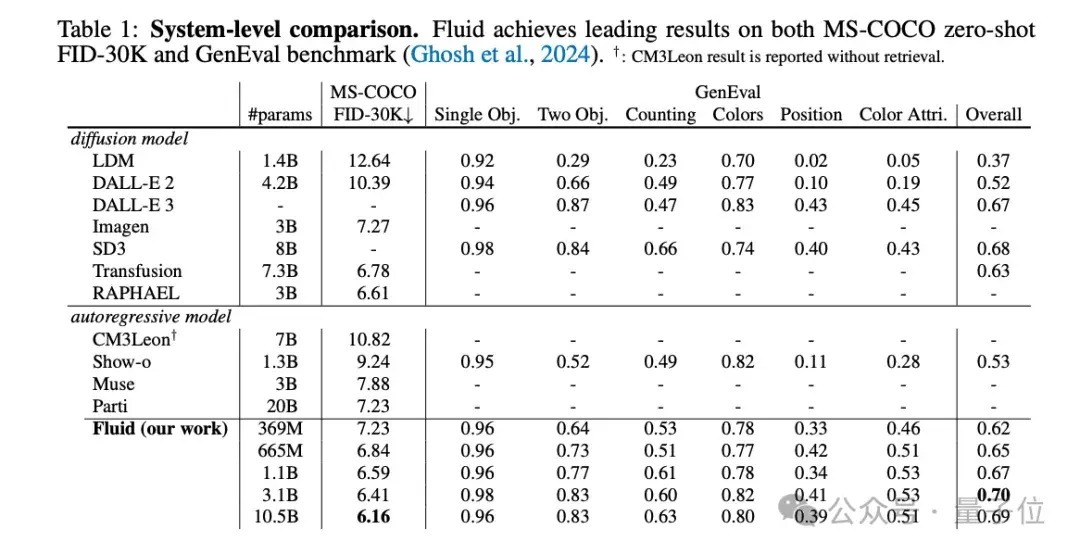

受到这些发现启发,团队磨练了Fluid,一个基于开发秀丽的立时法例自回首模子。

推广至百亿参数的Fluid在MS-COCO 30K上zero-shot条目下达成了6.16的FID分数,并在GenEval基准测试中取得了0.69的举座得分。

团队但愿这些发现和效果大致饱读吹改日进一步弥合视觉和说话模子之间的范畴差距。

100亿参数自回首文生图模子

追忆往常,两个要道规画身分甘休了自回首图像生成模子的性能弘扬:

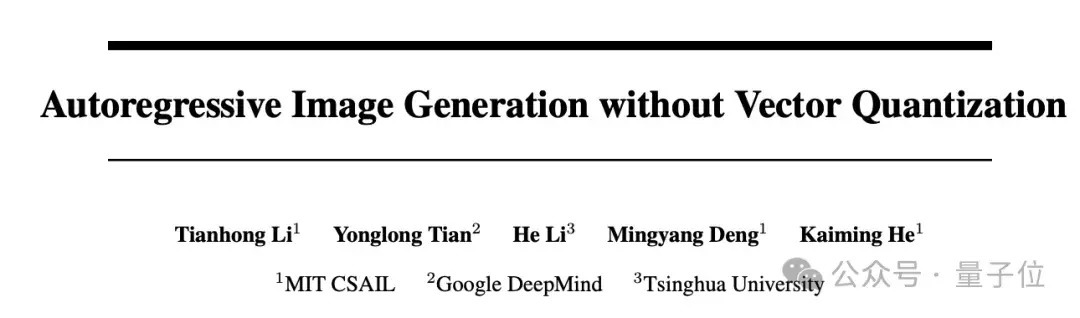

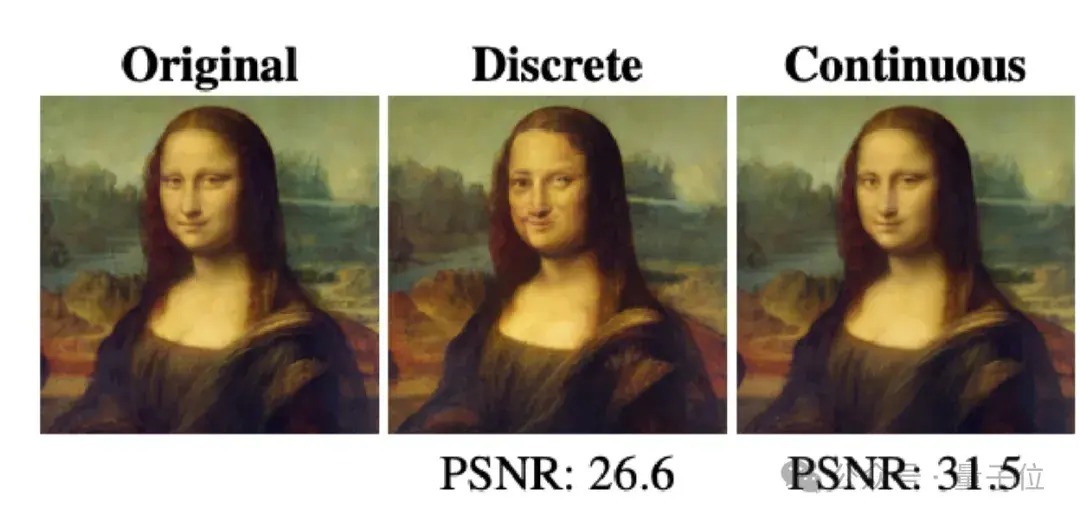

错杂token。大多数此类模子鉴戒NLP的作念法,先用vector-quantized(VQ)时势将图像错杂化为一组token,每个token只可取有限的错杂值。这种量化不免失掉大宗信息。光栅法例。即按从左到右、从上到下的固定法例生成token。这种神色虽故意于推理加快,但也影响了生成质地。Fluid给与了团队在本年6月份看管《Autoregressive Image Generation without Vector Quantization》的念念路,消除错杂token,改用开发token。

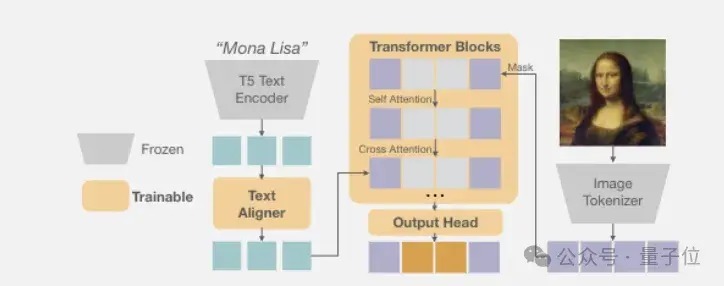

它鉴戒了扩散模子,用一个微型去噪网罗近似每个token的开发分离。

具体而言,模子为每个位置的token生成一个向量z算作条目,输入一个微型去噪网罗。这个去噪网罗界说了token x在给定z时的条目分离p(x|z)。磨练时,该网罗与自回首模子联结优化;推理时,从p(x|z)中采样即可得到token。所有这个词历程无需错杂化,幸免了量化失掉。

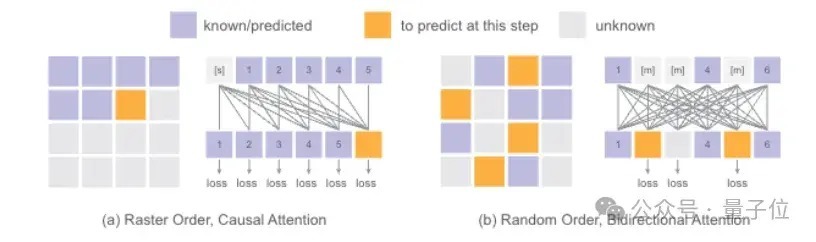

再来望望生成token的法例。按固定的光栅法例一一生成token,推理时天然不错用kv缓存加快,但因果相干的甘休也影响了生成质地。

Fluid匠心独具,立时取舍要生成的token,并用访佛BERT双向注目力的机制捕捉全局信息。

在推理时取舍足够立时法例,磨练和推理历程的序列分离更一致;同期还能对每个token进行访佛GPT的temperature采样,进一步进步了生成各样性。

收获于扩散损结怨MAR范式的双重加握,作家将模子参数目推广到独特100亿,在MS-COCO和GenEval数据集上取得率先效果。

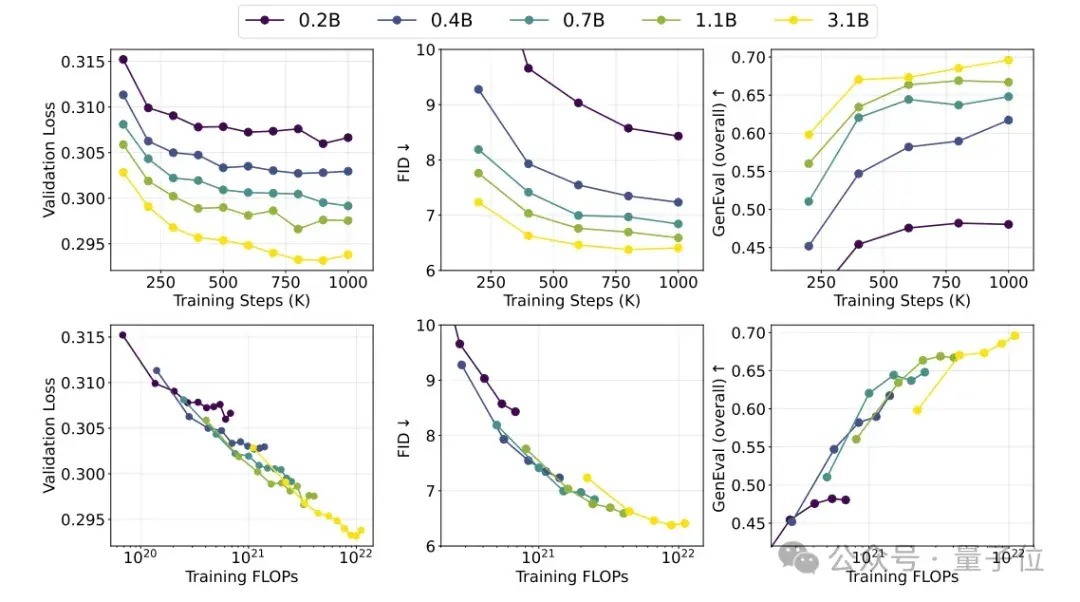

更抨击的是,跟着参数目和磨练轮数的加多,模子在考证失掉、FID、GenEval Score等目标上弘扬出精良的可推广性,为进一步扩大范畴提供了表面撑握。这与说话模子的Scaling舒畅止境访佛,标明视觉大模子的后劲尚未被充分挖掘。

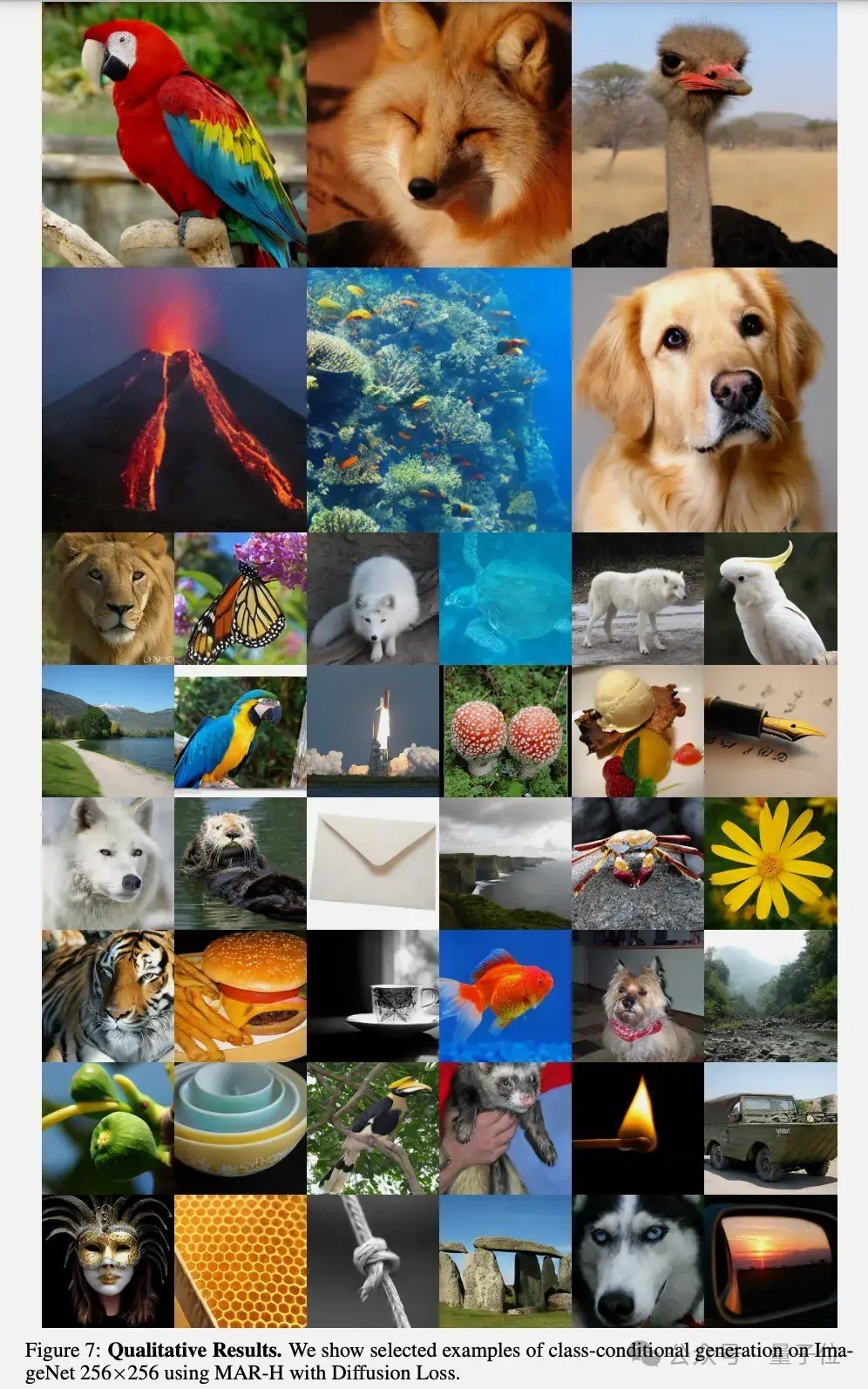

更多Fuild模子生成图像精选:

论文地址:

抠逼https://arxiv.org/abs/2410.13863— 完 —

量子位 QbitAI · 头条号签约

关怀咱们麻仓优快播,第一手艺获知前沿科技动xtt